Развитие больших языковых моделей за последние годы вышло за рамки простого наращивания параметров. Индустрия столкнулась с ограничениями по стоимости обучения, энергопотреблению и качеству обобщения знаний. На этом фоне архитектура обучения DeepSeek с подходом mHC стала одной из наиболее обсуждаемых концепций нового поколения. Она предлагает не очередную модификацию трансформера, а иной взгляд на то, как модель усваивает знания, распределяет вычисления и формирует устойчивые представления. В этой статье подробно и без формул разбирается, что такое mHC, почему он появился и чем принципиально отличается от привычных методов обучения нейросетей.

Почему классические схемы обучения ИИ упёрлись в пределы

На протяжении нескольких лет доминирующей стратегией в развитии языковых моделей оставалось масштабирование. Больше данных, больше параметров, больше вычислительных ресурсов — такой подход действительно давал ощутимый прирост качества. Однако со временем стало очевидно, что эта модель роста не может продолжаться бесконечно. Стоимость обучения одной крупной нейросети измеряется десятками миллионов долларов, а инфраструктурные требования становятся неподъёмными даже для технологических гигантов.

Помимо экономического фактора проявились и качественные ограничения. Классические схемы обучения плохо справляются с задачами переноса знаний между доменами, склонны к переобучению на частотных паттернах и демонстрируют нестабильность при усложнении логических рассуждений. Модель может выглядеть «умной» на тестах, но терять адекватность при выходе за рамки шаблонных запросов.

Важным сигналом кризиса стало и то, что рост параметров перестал давать линейный прирост качества. Каждый следующий шаг масштабирования требует всё больших затрат ради всё меньшего выигрыша. Это заставило исследователей искать альтернативы: архитектурные изменения, новые методы обучения и переосмысление самой логики формирования интеллекта в модели. Именно в этом контексте появился подход DeepSeek и его архитектура mHC, ориентированная не на экстремальное масштабирование, а на более «умное» обучение.

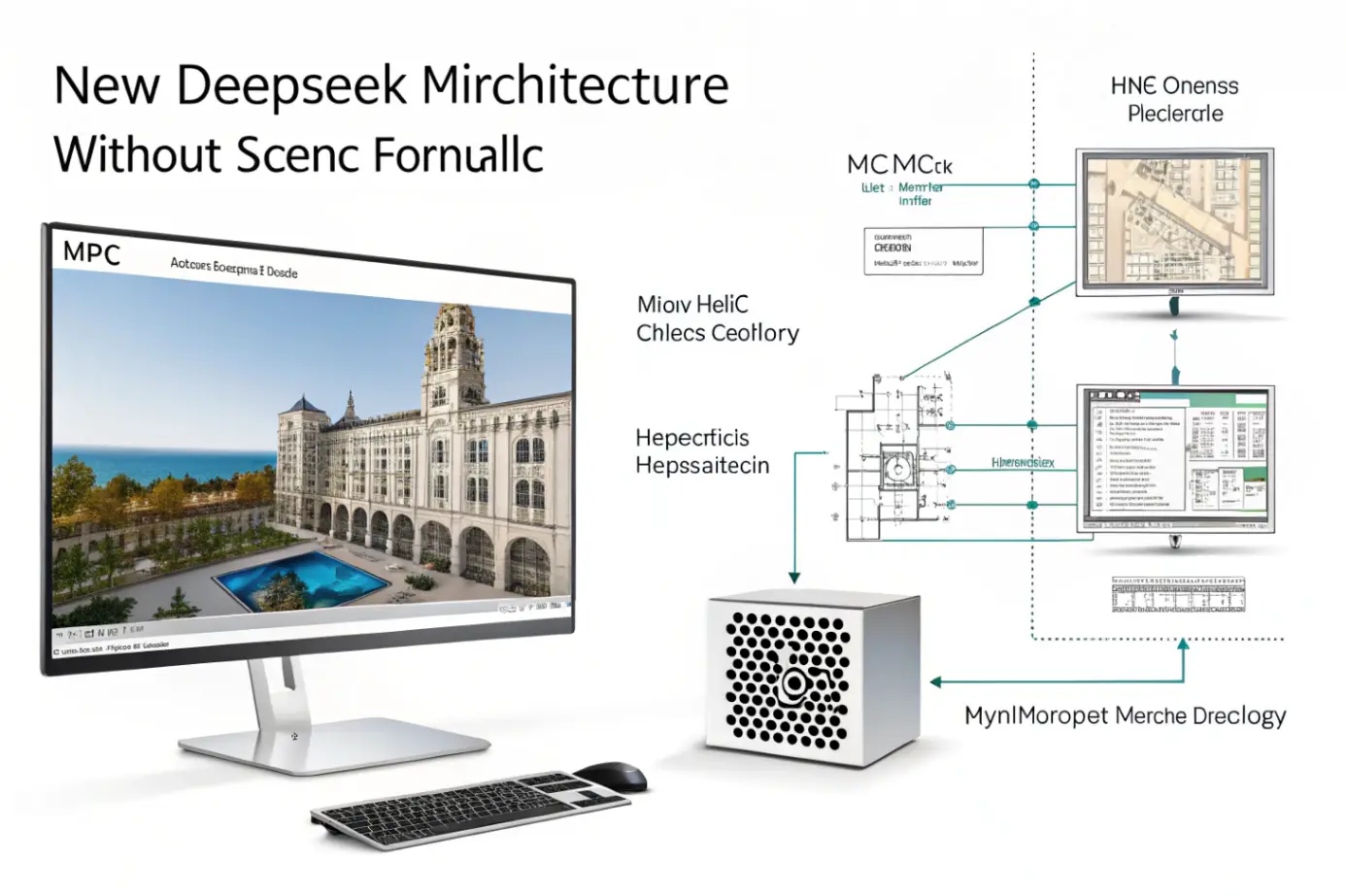

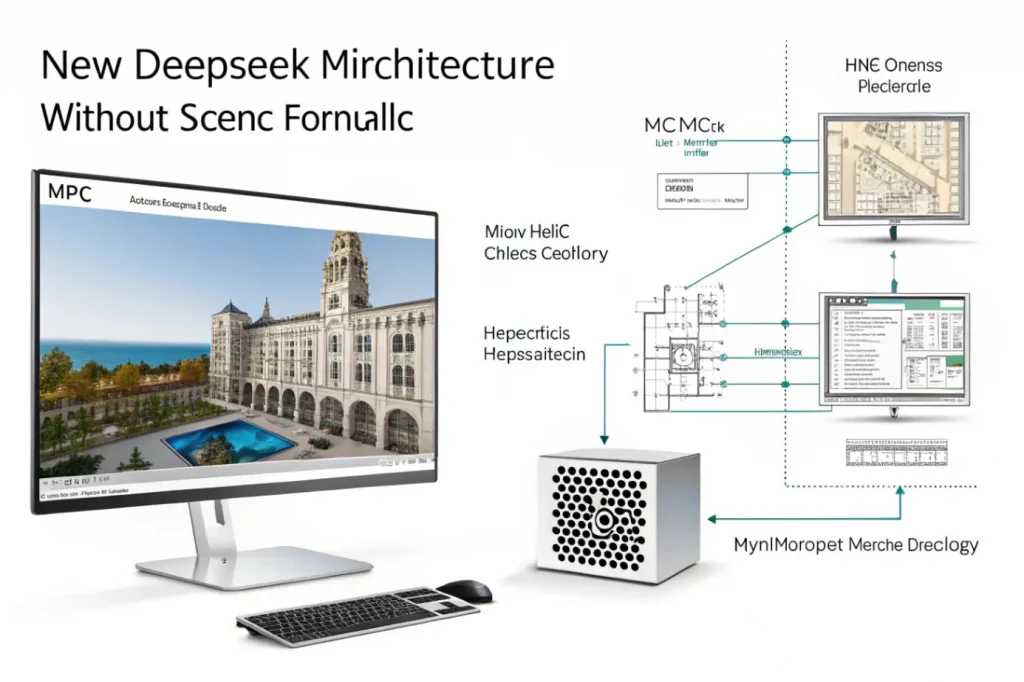

Что такое mHC и как устроена архитектура DeepSeek

Архитектура mHC в DeepSeek строится вокруг идеи многоуровневой когнитивной иерархии. Вместо того чтобы обучать модель как единое монолитное целое, обучение разбивается на логические уровни, каждый из которых отвечает за свой тип представлений. Это позволяет модели не просто запоминать статистику данных, а формировать более устойчивые и интерпретируемые структуры знаний.

Важной особенностью mHC является разделение процессов восприятия, обобщения и принятия решений. В классических трансформерах эти процессы тесно переплетены, что делает модель эффективной, но плохо управляемой. В DeepSeek архитектура обучения организована так, чтобы разные слои и модули специализировались на разных когнитивных задачах, сохраняя при этом целостность поведения.

Ниже представлена обобщающая таблица, которая помогает понять ключевые элементы архитектуры mHC и их роль в обучении модели.

| Компонент архитектуры | Роль в обучении | Практический эффект |

|---|---|---|

| Иерархические уровни представлений | Формирование абстракций разного масштаба | Более устойчивое понимание контекста |

| Адаптивное распределение вычислений | Динамическое использование ресурсов | Снижение стоимости обучения |

| Контекстно-зависимая активация модулей | Активация нужных подсистем под задачу | Рост точности ответов |

| Разделение обучения и рассуждения | Минимизация интерференции знаний | Лучшее логическое поведение |

Эта таблица показывает, что mHC — это не один алгоритм, а целостная система принципов. После внедрения такой структуры обучение перестаёт быть линейным процессом «данные — градиенты — параметры». Модель учится поэтапно, закрепляя знания на разных уровнях абстракции, что принципиально меняет её поведение при реальном использовании.

Принцип многоуровневого обучения без математических деталей

Ключевая идея mHC заключается в том, что интеллект не формируется на одном уровне. Человеческое мышление строится иерархически: мы сначала распознаём символы, затем смыслы, затем связи между смыслами и только потом формируем выводы. DeepSeek пытается воспроизвести эту логику в архитектуре обучения нейросети.

В процессе обучения модель не просто «прогоняет» текст через слои. Она формирует устойчивые представления, которые могут использоваться повторно в разных задачах. Это снижает необходимость каждый раз заново вычислять всё с нуля и уменьшает шум, связанный с противоречивыми данными.

Особенно важно, что в mHC обучение разных уровней может происходить с разной скоростью и интенсивностью. Это позволяет избежать ситуации, когда поверхностные паттерны подавляют более глубокие логические структуры. В результате модель становится менее зависимой от частотных шаблонов и лучше справляется с редкими или нестандартными запросами.

Для лучшего понимания можно выделить несколько ключевых особенностей такого обучения, которые логично вытекают из архитектуры mHC:

- формирование устойчивых семантических слоёв, не зависящих от конкретных формулировок;

- снижение взаимного «шума» между задачами разной сложности;

- возможность адаптивного дообучения без разрушения базовых знаний;

- более предсказуемое поведение модели в новых доменах.

Этот список иллюстрирует не технические детали, а практическую философию подхода. После него становится понятнее, почему DeepSeek демонстрирует стабильность и логичность даже при меньшем количестве параметров по сравнению с традиционными моделями.

Отличия mHC от стандартных трансформерных подходов

Хотя DeepSeek формально может использовать элементы трансформерной архитектуры, его подход к обучению принципиально отличается от классических схем. В стандартных моделях все слои работают в рамках одного общего пространства представлений, а различия между ними носят скорее количественный, чем качественный характер.

В mHC каждый уровень имеет свою функциональную роль. Одни слои отвечают за базовую языковую структуру, другие — за семантику, третьи — за логические зависимости и долгосрочные связи. Это позволяет избежать эффекта «размазывания» знаний, когда важные концепции теряются среди статистического шума.

Ещё одно важное отличие — отношение к контексту. В классических моделях контекст обрабатывается линейно, и его расширение приводит к экспоненциальному росту вычислений. В архитектуре DeepSeek контекст структурируется, а разные его части активируют разные когнитивные уровни. Это делает работу с длинными и сложными запросами более эффективной.

В итоге mHC можно рассматривать как шаг от универсального статистического приближения к более осмысленной архитектуре, в которой обучение и использование знаний становятся ближе к человеческой когнитивной модели.

Влияние архитектуры mHC на качество рассуждений

Одним из самых заметных эффектов внедрения mHC стало улучшение качества рассуждений. Модель начинает демонстрировать не просто последовательность логичных фраз, а способность удерживать причинно-следственные связи на протяжении длинного ответа. Это особенно важно для аналитических, технических и образовательных задач.

Архитектура обучения позволяет DeepSeek минимизировать противоречия внутри одного ответа. Поскольку разные уровни отвечают за разные аспекты мышления, вероятность логического конфликта снижается. Модель реже «забывает», что она уже сказала, и лучше согласует выводы с исходными предпосылками.

Кроме того, mHC способствует формированию более прозрачного поведения. Хотя модель всё ещё остаётся сложной системой, её реакции становятся менее хаотичными. Это повышает доверие со стороны пользователей и открывает путь к использованию таких моделей в критически важных областях, где требуется стабильность и предсказуемость.

Практические последствия для обучения и внедрения ИИ

С практической точки зрения архитектура mHC меняет не только поведение модели, но и подход к её разработке. Обучение становится более модульным, что упрощает эксперименты и доработки. Разработчики могут улучшать отдельные уровни, не переобучая всю модель целиком.

Это также снижает порог входа для команд с ограниченными ресурсами. Вместо гигантских вычислительных кластеров можно сосредоточиться на оптимизации конкретных компонентов. Такой подход делает развитие ИИ более доступным и разнообразным.

Для бизнеса это означает снижение затрат, ускорение внедрения и более точную адаптацию моделей под конкретные задачи. DeepSeek с архитектурой mHC демонстрирует, что качество ИИ может расти не только за счёт масштабирования, но и за счёт более продуманной структуры обучения.

Будущее архитектур обучения на примере DeepSeek

Архитектура mHC может рассматриваться как один из первых шагов к посттрансформерной эпохе. Она показывает, что дальнейший прогресс в ИИ будет связан не столько с ростом размеров моделей, сколько с улучшением их внутренней организации.

Вероятно, в будущем мы увидим гибридные подходы, где идеи mHC будут сочетаться с другими архитектурными инновациями. Это приведёт к появлению более компактных, но при этом более «умных» моделей, способных к глубокому пониманию и рассуждению.

DeepSeek в этом контексте выступает не просто как очередная модель, а как экспериментальная платформа, демонстрирующая новое направление развития. Если этот подход получит широкое распространение, индустрия ИИ может перейти от гонки масштабов к гонке архитектурных идей.

Заключение

Архитектура обучения DeepSeek с подходом mHC представляет собой важный сдвиг в понимании того, как должны обучаться современные языковые модели. Отказ от слепого масштабирования в пользу многоуровневой когнитивной структуры открывает новые возможности для повышения качества, устойчивости и эффективности ИИ. Объяснённая без формул, эта концепция показывает, что будущее искусственного интеллекта лежит не только в количестве данных, но и в качестве их осмысления.